AI界掌管開源的神——DeepSeek回來了!

剛剛,DeepSeek開源了全新的數學模型DeepSeekMath-V2,專注于可自驗證的數學推理。

DeepSeekMath-V2不僅在IMO 2025和CMO 2024中取得金牌級分數,而且還在Putnam 2024中,得分118/120,超過了人類最高分90。

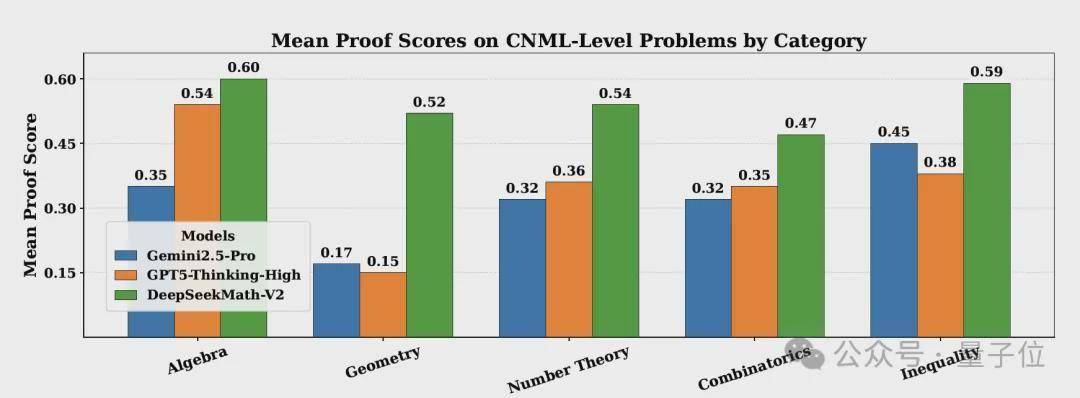

與此同時,DeepSeekMath-V2在所有CNML級別問題類別(代數、幾何、數論、組合學、不等式)上均優于GPT-5-Thinking-High和Gemini 2.5-Pro。

不僅性能無敵,網友表示這還是第一個開源的IMO金牌模型。

這下,谷歌和OpenAI要坐不住了!

特別是OpenAI,本來就打算放出IMO金牌模型來應對谷歌Gemini 3 Pro的沖擊,現在被DeepSeek搶先一步。

(鯨魚回來了!)

值得一提是,這篇論文的一作邵智宏也是之前DeepSeekMath 7B的一作,在那篇論文中,他們提出了著名的GRPO

最強開源IMO金牌模型

總的來說,DeepSeekMath-V2是一個旨在實現自驗證數學推理(Self-verification)的大型語言模型(685B)。

它的核心在于開發和利用強大的證明驗證能力來指導和優化證明生成,從而克服傳統上依賴最終答案作為獎勵的強化學習(RL)方法的局限性。

傳統用于數學推理的強化學習(RL)方法存在根本性限制:

最終答案獎勵的不可靠性:將LLM獎勵基于最終答案的正確性,并不能保證推理過程的正確性或邏輯的嚴謹性,模型可能通過錯誤的邏輯得出正確答案 。對定理證明任務的局限性:許多數學任務(如定理證明)不要求數值答案,而是需要嚴格的步驟推導和邏輯嚴謹性,使得基于最終答案的獎勵機制不適用。缺乏內部驗證能力:經過傳統方法訓練的LLMs缺乏驗證自身證明有效性的能力,經常表現出高假陽性率(即認為錯誤的證明是有效的)。

DeepSeekMath-V2采用迭代的強化學習循環,交替優化證明驗證器和證明生成器,以實現可自驗證的數學推理。

證明驗證

訓練驗證器

研究首先訓練一個準確且忠實的LLM-based驗證器,使其能夠根據人類專家的標準識別證明中的問題并評分。